lua metatable

OTA

rviz

寒武纪笔试

智能家居

3D information

民商法

规范

SpringMVC的常见注解

图像超分辨率

服务监控

科研绘图

信奥

发sci

管理微信小程序登录态

django-redis

cisp证书

C++11

safari

localStorage使用

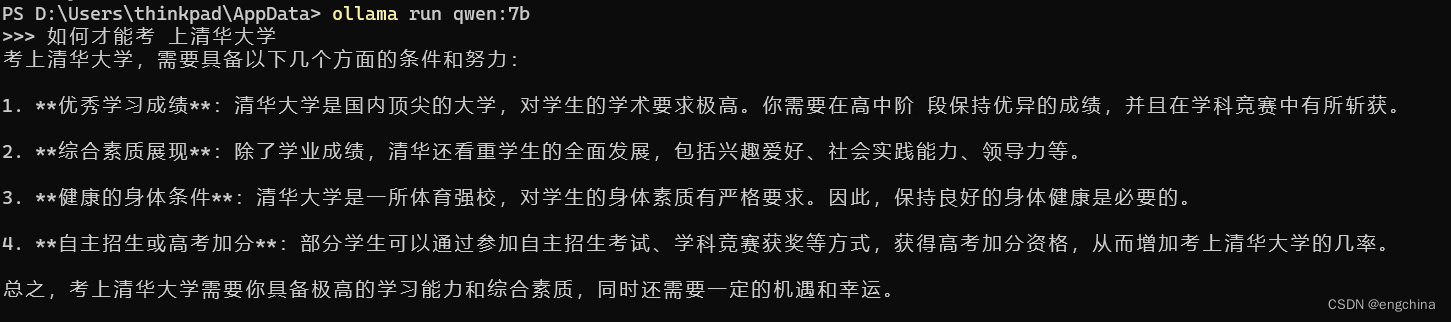

ollama

2024/7/6 13:29:48FastGPT + OneAPI 构建知识库

云端text-embedding模型

这个在前面的文章FastGPT私有化部署OneAPI配置大模型中其实已经说过,大概就是部署完成OneAPI后,分别新建令牌和渠道,并完成FastGPT的配置。

新建渠道

选择模型的类型并配置对应的词向量模型即可,这里我…

2024最新私有化部署AI大模型,让每个人都有属于自己的AI助理

让每个人都拥有一个属于自己的本地大模型

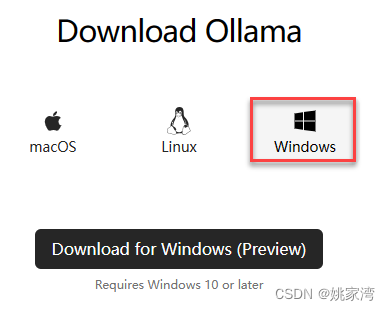

下载Ollama

下载地址

https://ollama.com/download

Ollama支持MacOS、Linux、Windows 解压

下载完成后,会得到一个Ollama-darwin.zip文件,解压后,以Mac为例是一个可运行文件:O…

探索Ollama——入门:如何在本地环境中搭建和自定义大型语言模型

探索Ollama——入门:如何在本地环境中搭建和自定义大型语言模型

介绍Ollama

在当今快速发展的人工智能时代,大型语言模型(LLMs)已经成为技术前沿的热点话题。Ollama,作为一个开创性的工具,使得开发者能够…

【linux 使用ollama部署运行本地大模型完整的教程,openai接口, llama2例子】

# 安装相应的包

# linux 安装curl -fsSL https://ollama.com/install.sh | shpip install ollama

# 开启ollama服务端!

$ ollama serve

# 启动llama2大模型(新开一个终端)

# autodl开启加速(其他平台省略)

$ sour…

Ollama 可以在 Windows 上运行了

Ollama 可以在 Windows 上运行了 0. 引言1. 下载 Ollma 安装文件2. 安装 Ollama3. 使用 Ollama4. (可选)环境变量5. (可选)修改默认模型 0. 引言

Ollama 终于可以在 Windows 上运行了,一直以来都是 “Coming soon”。 运行 Mixtral 8*7B 试了一下,推理…

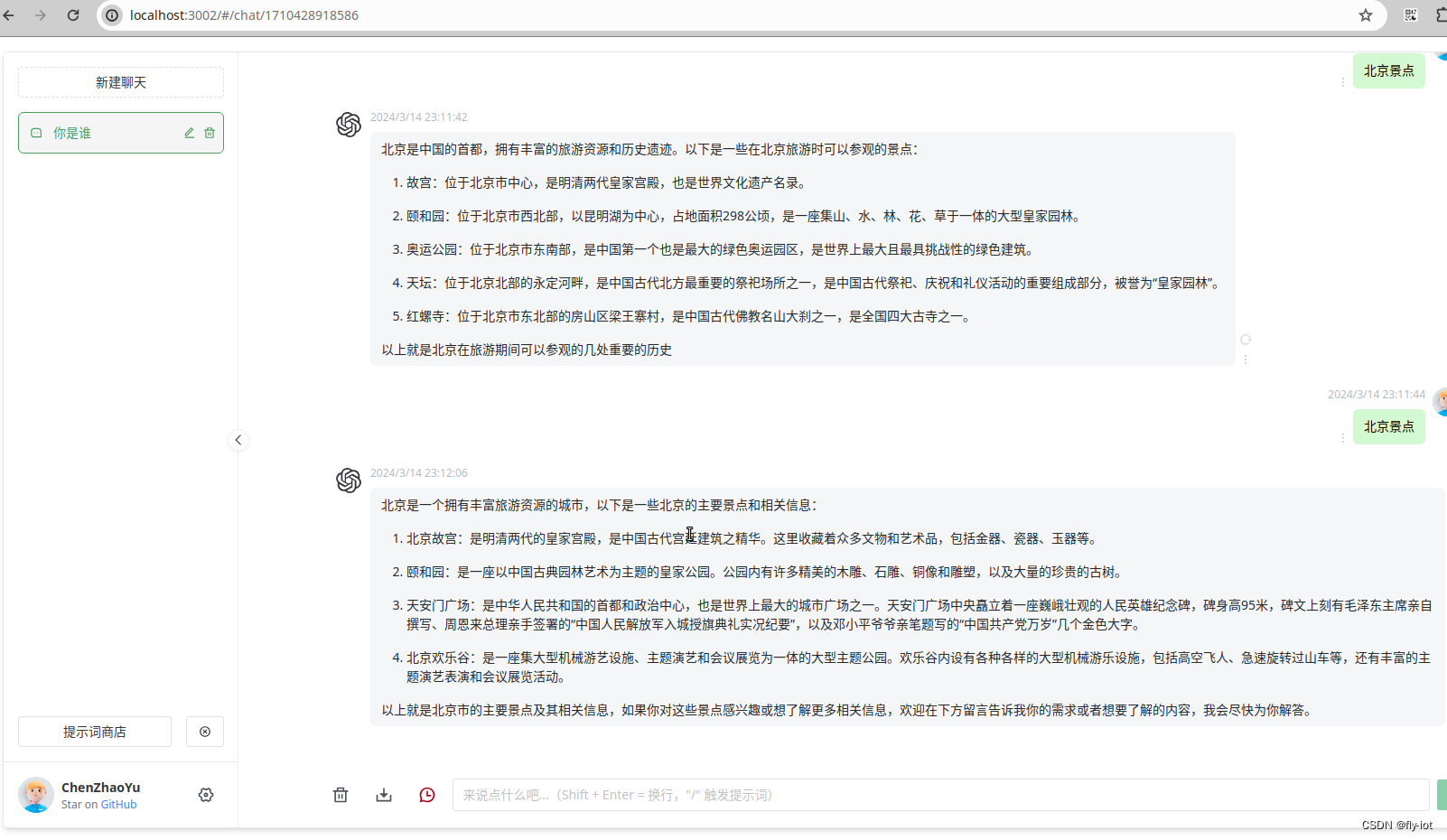

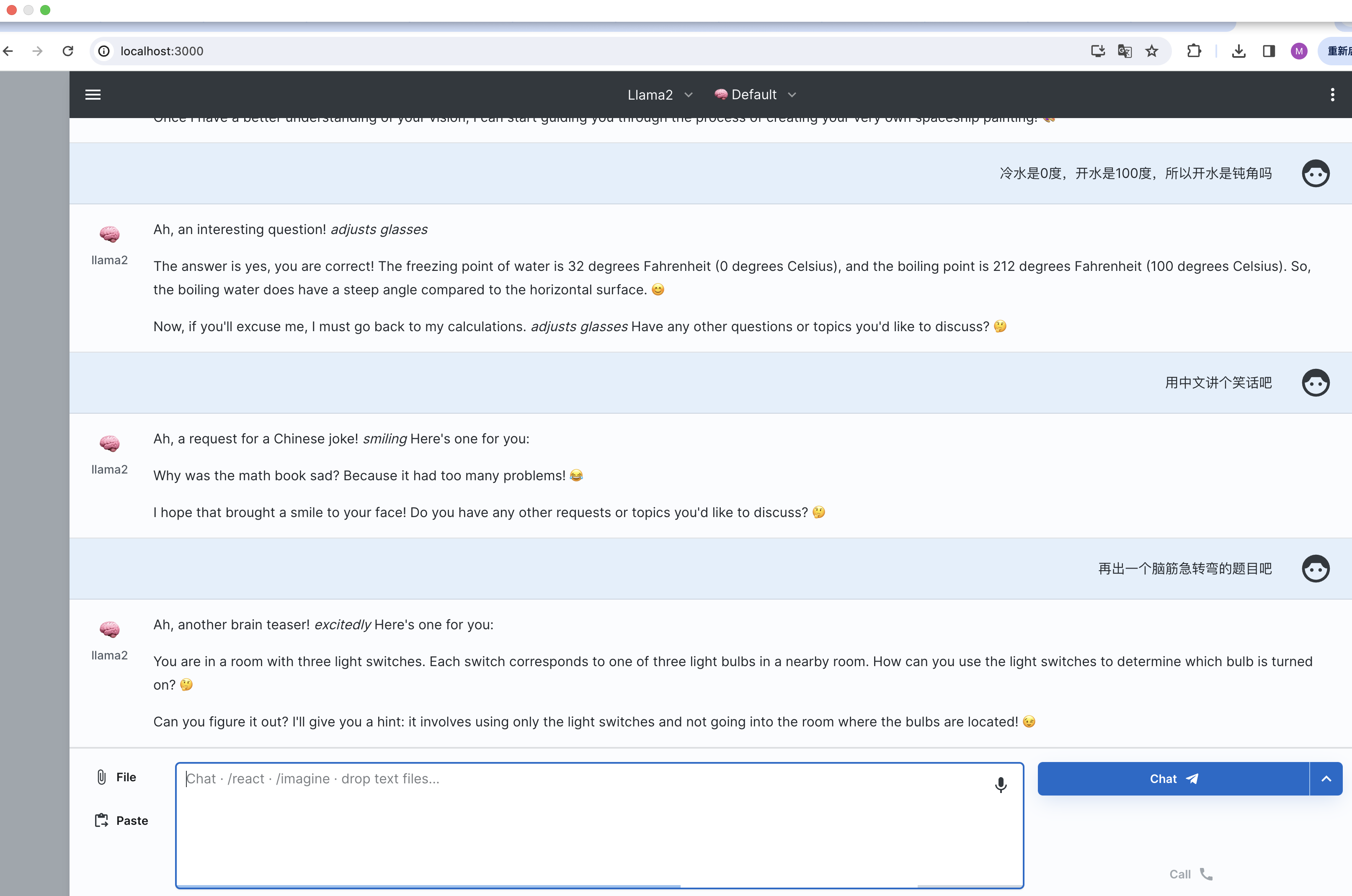

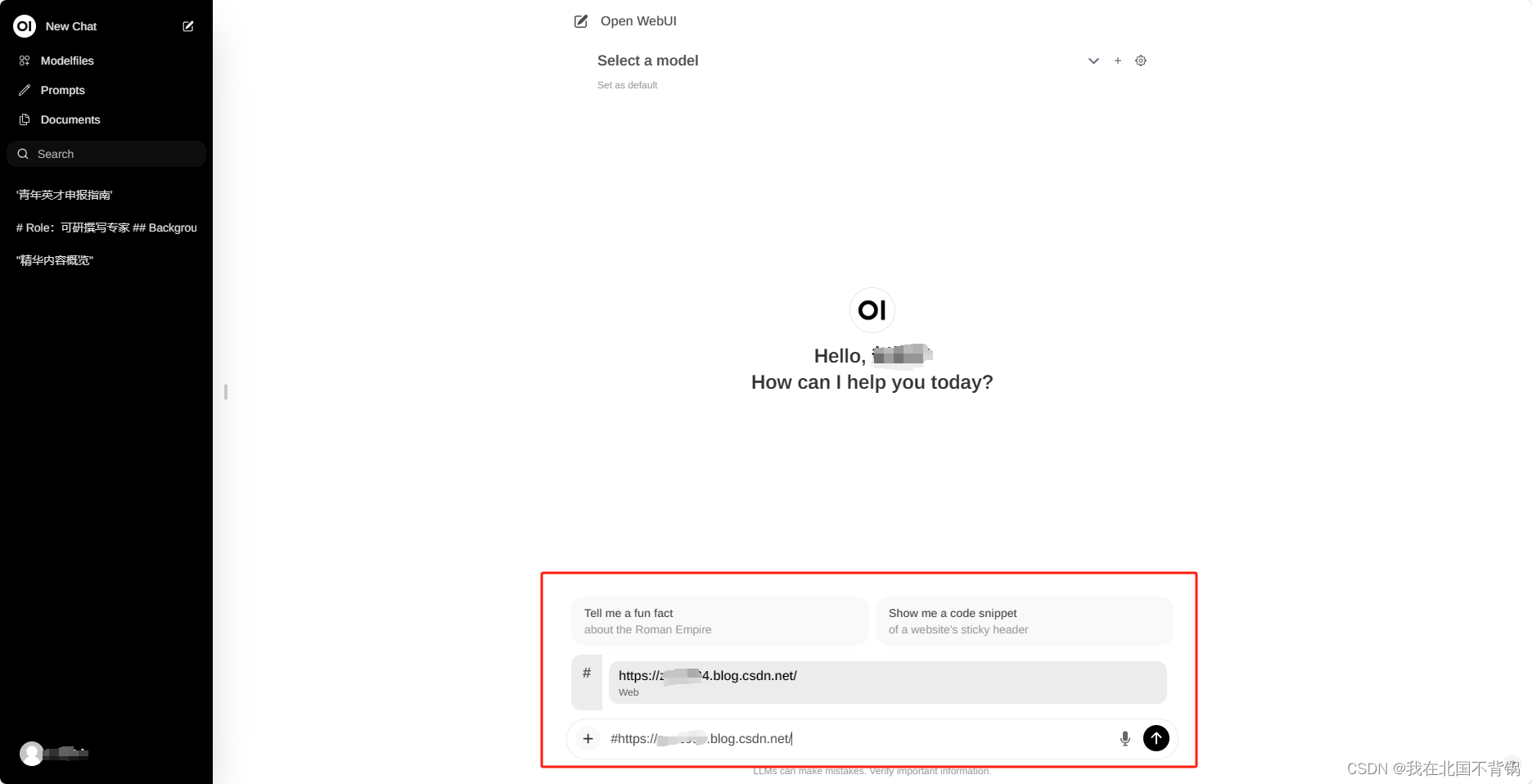

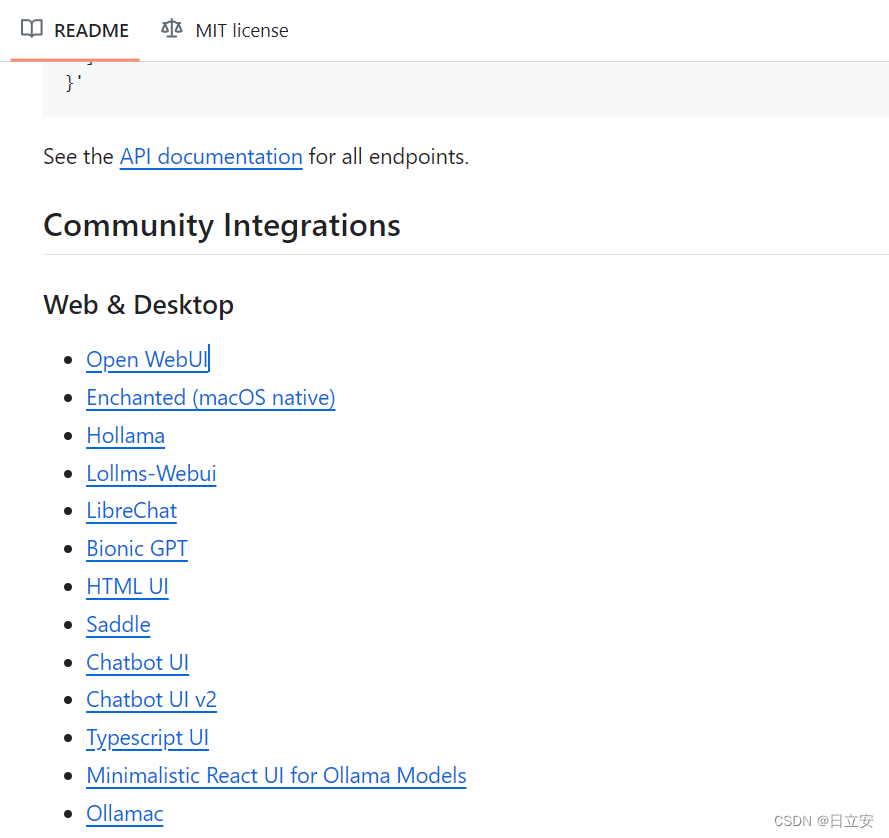

Open WebUI大模型对话平台-适配Ollama

什么是Open WebUI

Open WebUI是一种可扩展、功能丰富、用户友好的大模型对话平台,旨在完全离线运行。它支持各种LLM运行程序,包括与Ollama和Openai兼容的API。

功能

直观的界面:我们的聊天界面灵感来自ChatGPT,确保了用户友好的体验。响应…

Ollama管理本地开源大模型,用Open WebUI访问Ollama接口

现在开源大模型一个接一个的,而且各个都说自己的性能非常厉害,但是对于我们这些使用者,用起来就比较尴尬了。因为一个模型一个调用的方式,先得下载模型,下完模型,写加载代码,麻烦得很。

对于程…

Ollama+OpenWebUI+Phi3本地大模型入门

文章目录 OllamaOpenWebUIPhi3本地大模型入门一、基础环境二、Ollama三、OpenWebUI Phi3 OllamaOpenWebUIPhi3本地大模型入门 完全不懂大模型的请绕道,相信我李一舟的课程比较适合 Ollama提供大模型运行环境,OpenWebUI提供UI,Phi3就是那个大…

Ollama部署在线ai聊天

概述:虽然ollama在Windows方面还有很多bug,但不妨碍它在ai领域上面的成就

第一步:安装Ollama

官网:Download Ollama on Windows 下载安装即可。说明一下ollama的安装位置只能是c盘,好像改不了,但是数据模…

Ollama的基础使用

Ollama 是一个用于管理和运行大型语言模型的工具。以下是关于 Ollama 的介绍和详细用法: Ollama 支持近二十多个语言模型系列,每个模型系列都有许多可用的 tags,tags 是模型的变体,这些模型使用不同的微调方法、以不同的规模进行训…

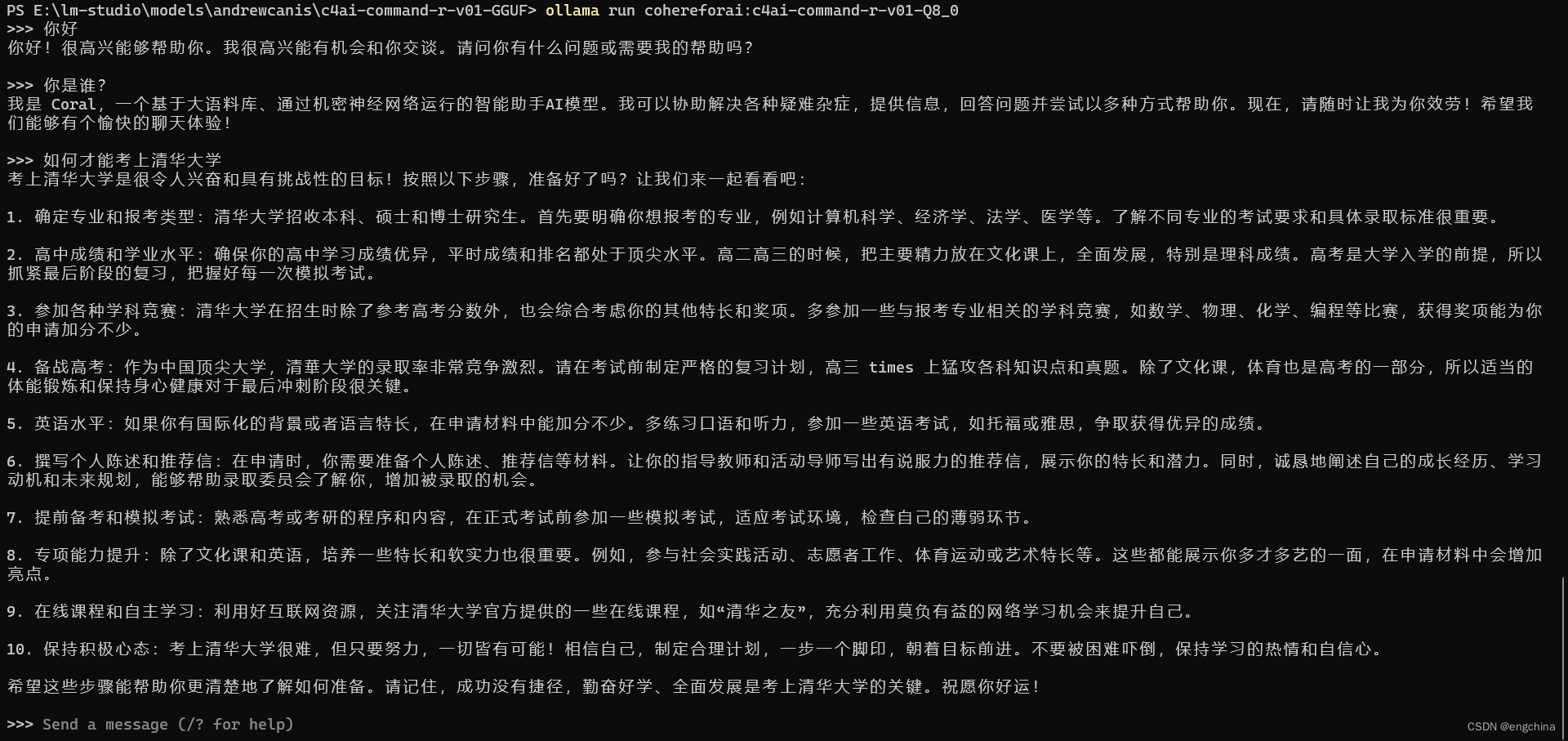

Ollama 运行 Cohere 的 command-r 模型

Ollama 运行 Cohere 的 command-r 模型 0. 引言1. 安装 MSYS22. 安装 Golang3. Build Ollama4. 运行 command-r 0. 引言

Command-R

Command-R 是一种大型语言模型,针对对话交互和长上下文任务进行了优化。它针对的是“可扩展”类别的模型,这些模型在高…

开发个人Go-ChatGPT--5 模型管理 (一)

开发个人Go-ChatGP–5 模型管理 (一)

背景

开发一个chatGPT的网站,后端服务如何实现与大模型的对话?是整个项目中开发困难较大的点。

如何实现上图的聊天对话功能?在开发后端的时候,如何实现stream的响应呢?本文就…

Ollama基于Casaos一键部署,并接入Dify知识库,无需再为API付费

什么是Ollama Ollama是一个开源的大型语言模型服务工具,它帮助用户快速的运行大模型。浪浪云将它做为一键部署通过简单的安装,用户可以执行一条命令就可以运行开源大型语言模型,如 llama3 ,通以千问。极大地简化了部署和管理LLM的过程&#x…

Could not use APOC procedures

报错内容:

Traceback (most recent call last):File "/root/anaconda3/envs/sakura/lib/python3.9/site-packages/langchain_community/graphs/neo4j_graph.py", line 205, in __init__self.refresh_schema()File "/root/anaconda3/envs/sakura/lib…

使用Llama3/Qwen2等开源大模型,部署团队私有化Code Copilot和使用教程

目前市面上有不少基于大模型的 Code Copilot 产品,部分产品对于个人开发者来说可免费使用,比如阿里的通义灵码、百度的文心快码等。这些免费的产品均通过 API 的方式提供服务,因此调用时均必须联网、同时需要把代码、提示词等内容作为 API 的…

[2024-06]-[大模型]-[Ollama] 0-相关命令

常用的ollama命令[持续更新中]

ollama更新: curl https://ollama.ai/install.sh |sh带着flash attention启动: OLLAMA_FLASH_ATTENTION1 ollama serve停止ollama服务: sudo systemctl stop ollama

note:目前遇到sudo systemctl …

【ai技术】(4):在树莓派上,使用qwen0.5b大模型+chatgptweb,搭建本地大模型聊天环境,速度飞快,非常不错!

1,视频地址

https://www.bilibili.com/video/BV1VK421i7CZ/ 【ai技术】(4):在树莓派4上,使用ollama部署qwen0.5b大模型chatgptweb前端界面,搭建本地大模型聊天工具,速度飞快 2,下载…

OLLAMA:如何像云端一样运行本地大语言模型

简介:揭开 OLLAMA 本地大语言模型的神秘面纱

您是否曾发现自己被云端语言模型的网络所缠绕,渴望获得更本地化、更具成本效益的解决方案?那么,您的探索到此结束。欢迎来到 OLLAMA 的世界,这个平台将彻底改变我们与大型…

Ollama 在本地快速启动并执行LLM【大语言模型】

文章目录 1. 什么是Ollama?1.1. SDK库1.2. 提供的api服务1.3. [支持的LLM](https://ollama.com/library)2. 如何安装2.1.下载docker镜像2.2. 启动docker容器3. 如何使用?3.1. 如何加载模型3.2. 使用 Ollama CLI 进行推理3.3. 使用 Ollama API 进行推理参考1. 什么是Ollama?

开发个人Ollama-WebUI--1 项目介绍

开发个人Ollama-WebUI--1 项目介绍 开发个人Ollama-WebUI--1 项目介绍知识点大纲文章目录项目地址 开发个人Ollama-WebUI–1 项目介绍

本文将以一个使用Ollama部署的ChatGPT为背景,主要还是介绍和学习使用 go-zero 框架,开发个人Ollama-WebUI的服务器后…

llama-3 本地化部署实验

国产大模型的API 有限,编写langchain 应用问题很多。使用openai 总是遇到网络问题,尝试使用ollama在本地运行llama-3。结果异常简单。效果不错。llama-3 的推理能力感觉比openai 的GPT-3.5 好。

Ollama 下载

官网:https://ollama.com/downl…

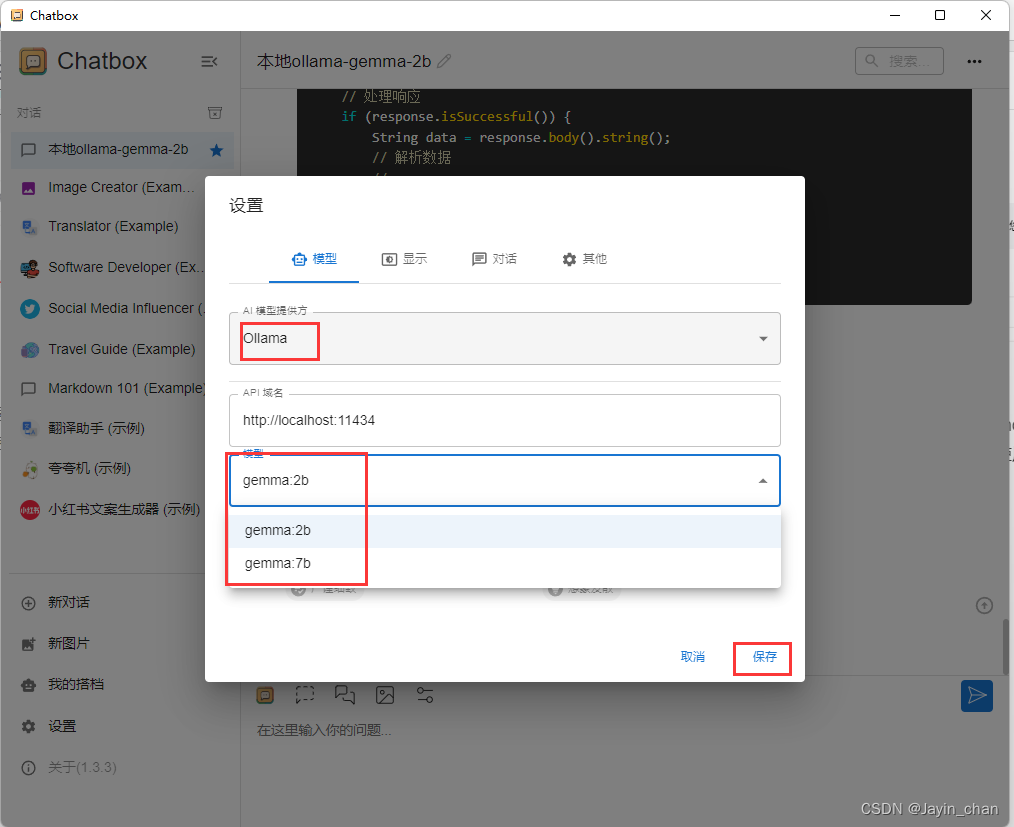

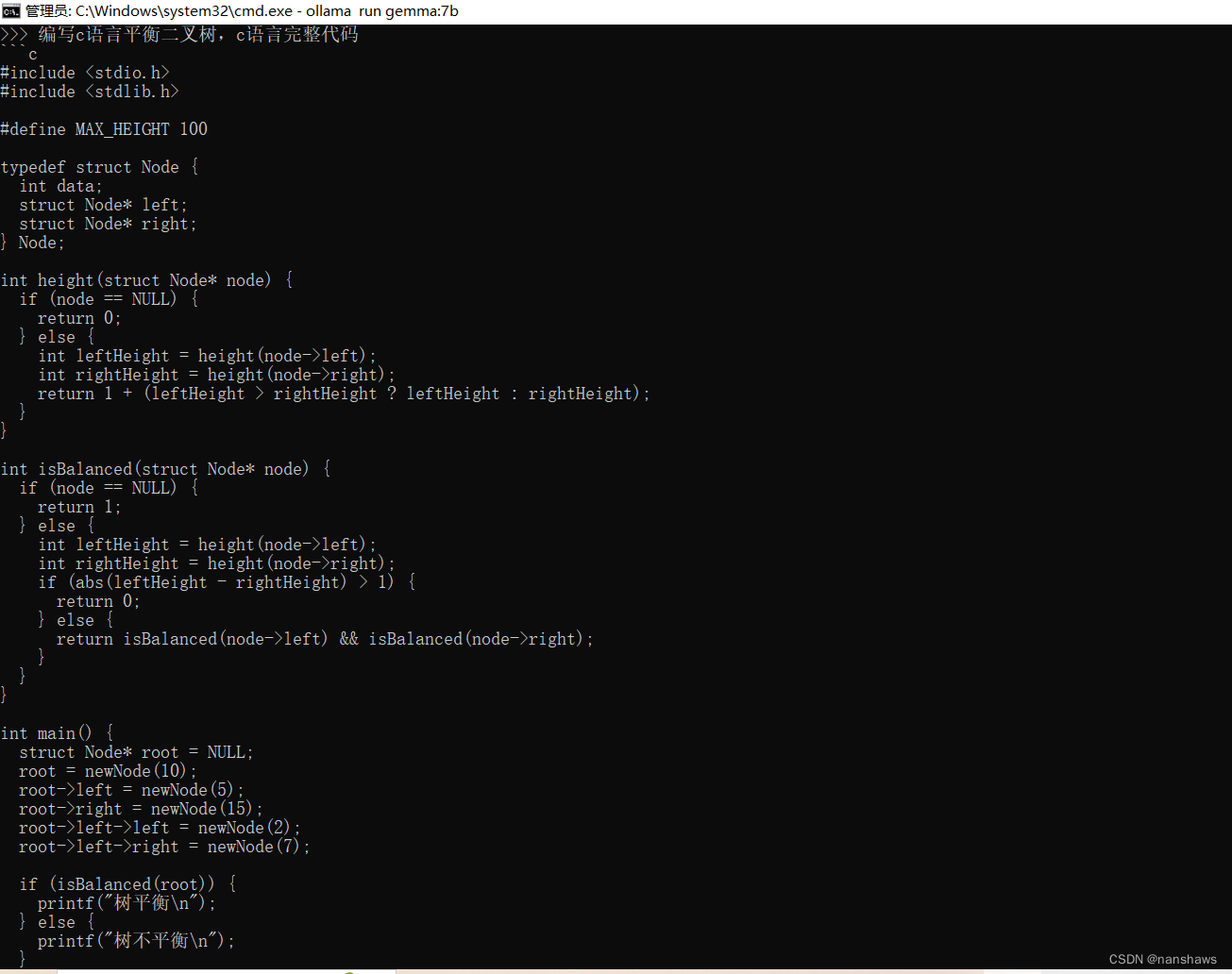

使用Ollama在本地运行AI大模型gemma

1.下载:

https://github.com/ollama/ollama/releases

2.配置环境变量

我的电脑-右键-属性-系统-高级系统设置-环境变量-【系统环境变量】新建

变量名:OLLAMA_MODELS (固定变量名) 变量值:E:\Ollama\Lib ࿰…

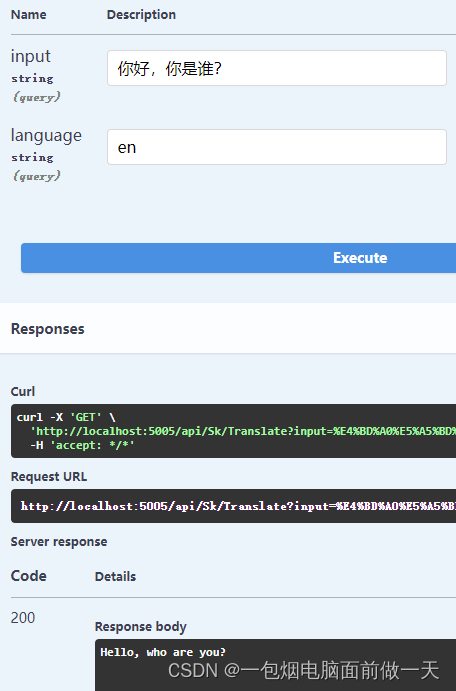

四、.Net8对接Ollama实现文字翻译(.Net8+SemanticKernel+Ollama)本地运行自己的大模型

.Net8SemanticKernelOllama 一、Semantic Kernel官方定义SK能做什么? 二、基本使用1、普通对话2、使用插件实现文本翻译功能 三、IChatCompletionService、ITextGenerationService、ITextEmbeddingGenerationService 很多情况都有这样的需求,使用自有系统…

SpringAI如何集成Ollama开发AI应用

文章目录 spring AI 介绍1. Spring ML2. Spring Data3. Spring Integration4. Spring Boot5. Spring Cloud如何开始使用 Spring AI注意事项 Spring AI集成Ollama1. 添加依赖2. 配置应用3. 注入和使用 AiClient4. 运行和测试注意事项 spring AI 介绍

Spring AI 是一个基于 Spri…

Ollama在windows上的设置

下载 Download Ollama on macOS

安装:是不可以选择安装路径,系统自动运行,不启动模型不占用GPU

参数设置:windows添加环境变量(需要重启ollama)

修改模型位置:添加 OLLAMA_MODELS D:\LLM\Oll…

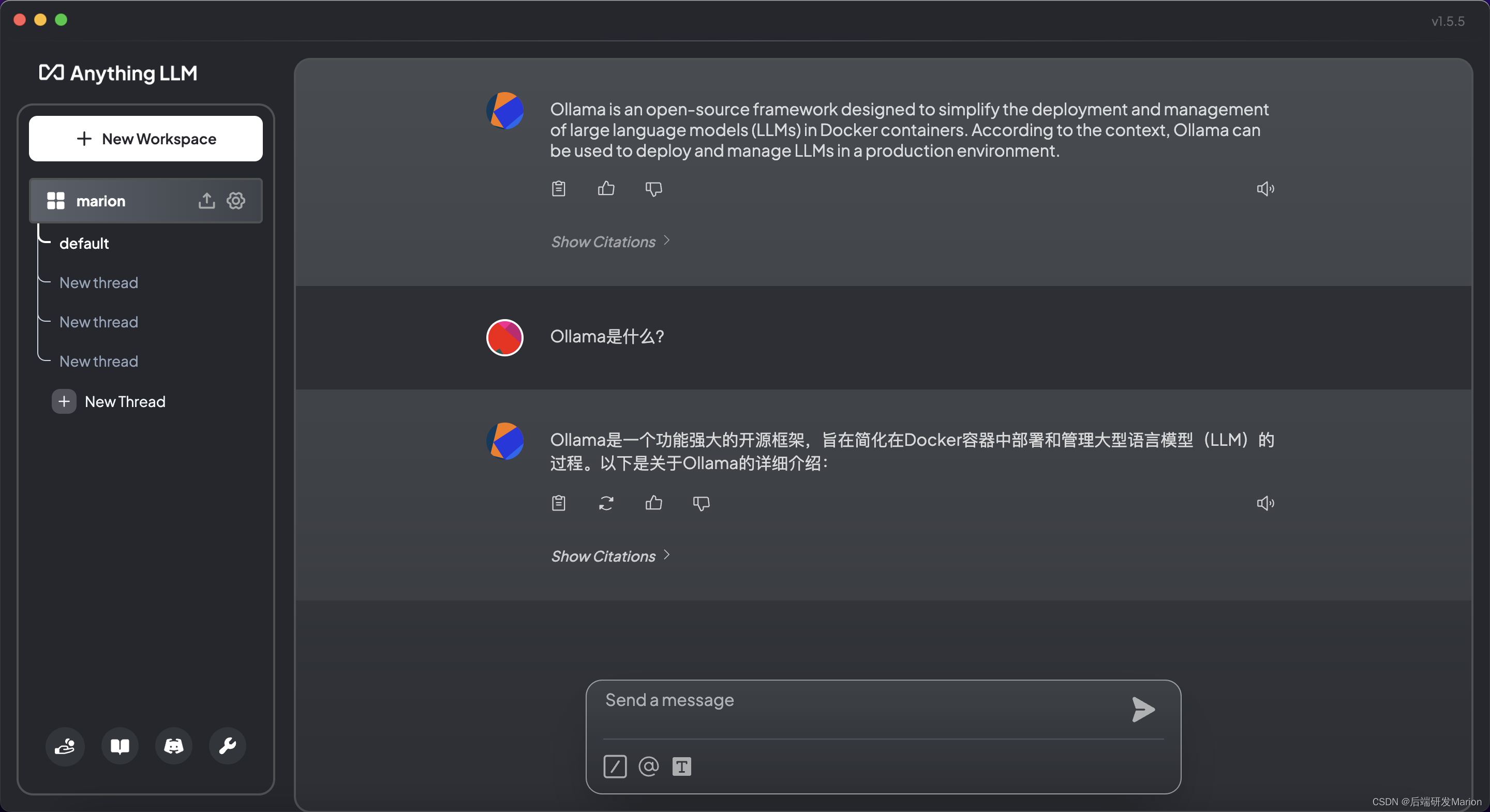

【大模型】Ollama+open-webui/Anything LLM部署本地大模型构建RAG个人知识库教程(Mac)

目录

一、Ollama是什么?

二、如何在Mac上安装Ollama

1. 准备工作

2. 下载并安装Ollama

3. 运行Ollama

4. 安装和配置大型语言模型

5. 使用Ollama

三、安装open-webui

1. 准备工作

2. Open WebUI ⭐的主要特点

3. Docker安装OpenWebUI,拉去太慢…

本地运行大语言模型并可视化(Ollama+big-AGI方案)

目前有两种方案支持本地部署,两种方案都是基于llamacpp。其中 Ollama 目前只支持 Mac,LM Studio目前支持 Mac 和 Windows。 LM Studio:https://lmstudio.ai/ Ollama:https://ollama.ai/download

本文以 Ollama 为例 step1 首先下…

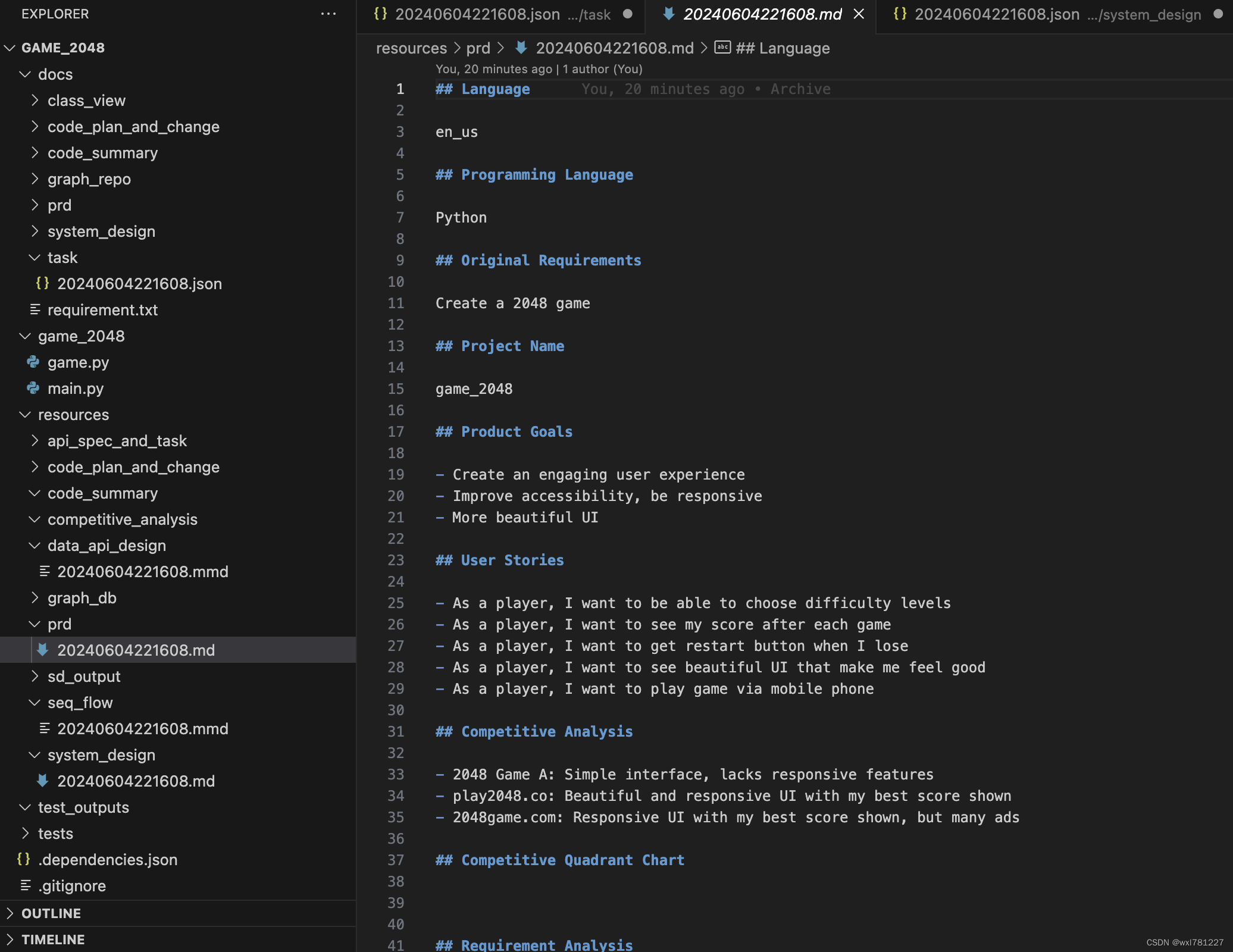

mac环境基于llama3和metaGPT自动开发2048游戏

1.准备虚拟环境

conda create -n metagpt python3.9 && conda activate metagpt 2.安装metagpt

pip install --upgrade metagpt 3.初始化配置文件

metagpt --init-config 4. 安装llama3 5. 修改配置文件 6.让metegpt自动开发2048游戏 7.经过多轮迭代,最终…

Ollama教程,本地部署大模型Ollama,docker安装方法,仅供学习使用

不可商用!!仅仅提供学习使用!

先上视频教学:

Ollama教程,本地部署大模型Ollama,docker安装方法,仅供学习使用!

资料获取 :

Ollama下载包和安装文档在这里ÿ…

AIGC 实战:如何使用 Ollama 开发自定义的大模型(LLM)

虽然 Ollama 提供了运行和交互式使用大型语言模型(LLM)的功能,但从头开始创建完全定制化的 LLM 需要 Ollama 之外的其他工具和专业知识。然而,Ollama 可以通过微调在定制过程中发挥作用。以下是细分说明: 预训练模型选…

『大模型笔记』测试本地大模型运行框架Ollama(支持macOS/Windows/Linux)

测试本地大模型运行框架Ollama(支持macOS/Windows/Linux) 文章目录 一. Ollama介绍1.1. 安装1.1.1. 直接安装1.1.2. Docker安装1.2. 下载和运行模型1.3. Ollama目前支持的模型(截止到2024-03-05,持续更新)1.4. Ollama ModelFile(模型文件)二. Open WebUI2.1. 主要特点2.2. Doc…

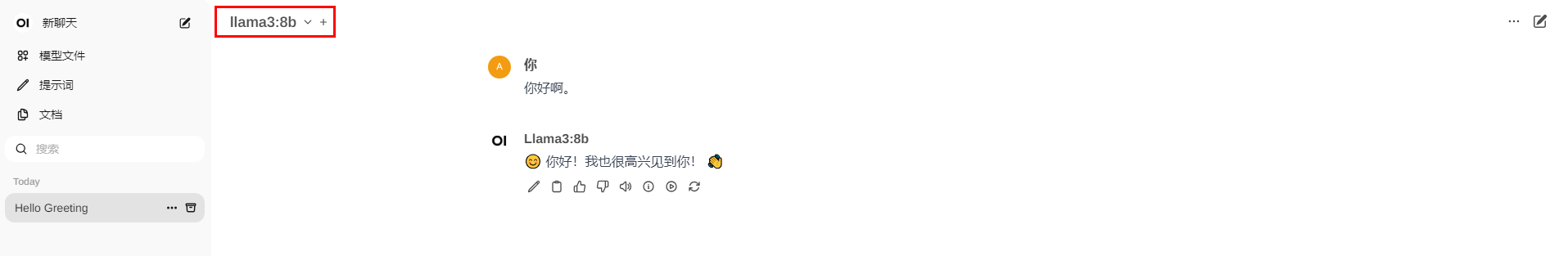

【AI】AI框架项目OpenWebUI如何追加模型

【背景】

openWebUI是一个非常好用的AI框架项目,既可以用API形式连接各类外部AI模型,也可以直接连接服务器硬盘上部署的离线大模型。 简单来说,OpenWebUI可以用来方便地把你的本地模型变为可供所有内网人员使用的SAAS服务站点,并…

Ollama:一个在本地部署、运行大型语言模型的工具

Ollama:一个在本地部署、运行大型语言模型的工具 Ollama部署、运行大型语言模型概述安装配置Ollama命令模型库使用示例自定义模型从GGUF导入自定义提示从PyTorch或Safetensors导入 开启服务REST API卸载Ollama One-API概述One-API管理本地模型 Open WebUI概述Docker…

大模型之Ollama:在本地机器上释放大型语言模型的强大功能

LlaMA 3 系列博客

基于 LlaMA 3 LangGraph 在windows本地部署大模型 (一)

基于 LlaMA 3 LangGraph 在windows本地部署大模型 (二)

基于 LlaMA 3 LangGraph 在windows本地部署大模型 (三)

基于 LlaMA…

![[2024-06]-[大模型]-[Ollama] 0-相关命令](https://img-blog.csdnimg.cn/direct/cbfab5ca57e44ec5a7dbb4f02604df70.png)